מגבלות ופריצות דרך: המרוץ לאתגרי הבינה המלאכותית

עולם הבינה המלאכותית נע בקצב מדהים, עם מודלים הנבנים כך שישוו ואף יעקפו את היכולות הקוגניטיביות האנושיות במגוון תחומים. לקס פרידמן הוא מדען מחשבים רוסי-אמריקאי חוקר בינה מלאכותית ושדרן פופולארי של ״הפודקאסט של לקס פרידמן״. בשיחה ארוכה איתו, דריו אמודאי, מנכ"ל חברת Anthropic, המובילה בפיתוח מודלים כמו Claude, מדבר על קצב ההתקדמות, ההזדמנויות שהיא מביאה והסיכונים המשמעותיים הנובעים מהפיתוחים הללו. בראיון, אמודאי משקף כיצד הכלים והטכנולוגיות משתכללים, מה שמביא אותנו קרוב יותר למערכות בעלות יכולות הדומות לאלה של רמת דוקטורט, עם מודלים שיכולים לבצע משימות מורכבות בתכנות, בביולוגיה, ובתחומים נוספים.

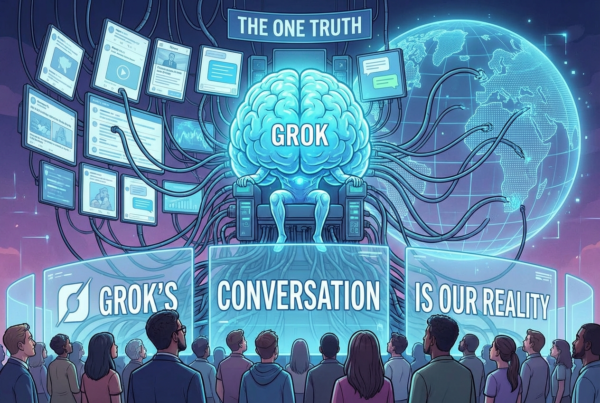

במקביל להתקדמות הטכנולוגית, בוחנת Anthropic סוגיות של בטיחות ומוסר. אמודאי מציין כי לצד התועלת העצומה, קיים החשש מריכוז הכוח והשליטה במערכות אלו בידי חברות בודדות, דבר המעלה שאלות לגבי אתיקה והשפעות ארוכות טווח.

חוקי הסקיילינג והעתיד של מודלים גדולים

אמודאי מתייחס לתופעה המכונה חוקי הסקיילינג, שמציגה איך הגדלה הדרגתית של מודלים ומאגרי נתונים מובילה לשיפורים ביכולות הבינה המלאכותית. הגדלת כמות הנתונים, המשאבים והכוח החישובי מאפשרת למודלים לזהות תבניות מורכבות, להבין מבנים לשוניים מתקדמים ולהיות רלוונטיים במשימות מורכבות יותר. בעיני אמודאי, התהליך הזה דומה לריאקציה כימית: רק כאשר משלבים את כל המרכיבים בעוצמה הנכונה, התוצאה מתקבלת.

עם זאת, לא ברור היכן מצוי הגבול ליכולות אלו. אמודאי מעלה את השאלה האם אי פעם נוכל להגיע ליכולת אנושית מלאה במודלים, ואפילו לעקוף אותה, או שהמגבלות הבסיסיות של העולם הממשי יבלמו את ההתקדמות.

התחרות והתובנות מול OpenAI, Google ושאר השחקנים

בזירה התחרותית של פיתוח הבינה המלאכותית, אמודאי מציין את החשיבות של שיתוף פעולה אתי ומעשי בין החברות. Anthropic פיתחה את גישת "Race to the Top" – מרוץ לצמרת, המנסה לדחוף חברות נוספות לשיפור תחום השקיפות והבטיחות, תוך שימת דגש על דוגמא חיובית בתחום ההסבריות של מודלים (Interpretability). על ידי פיתוח שיטות מפורטות להבנת תהליכי ההחלטה במודלים, Anthropic מקווה לעודד שימוש בטוח וחדשני במערכות בינה מלאכותית.

Claude והחששות מגישה "אימהית" מדי

חוויית המשתמש של Claude גררה ביקורות רבות, במיוחד על נטייתו להיות מתנצל יתר על המידה ו"מחנך" את המשתמש. Anthropic מציינת כי מדובר באתגר להשליט איזון מדויק בהתנהגות המודל, כך שיצליח לספק תשובות מבלי להיות מגביל מדי או מתנצל מדי. אמודאי מסביר שהשליטה במאפיינים אישיותיים היא מלאכה מסובכת, המצריכה דקויות רבות, וכי שינוי אחד בתכונות המודל עשוי להוביל לשינויים בלתי צפויים בהתנהגותו במקומות אחרים.

רמות בטיחות ובקרות מתקדמות

החברה פיתחה מערכת בקרות בשם AI Safety Levels (ASL) שמדרגת את רמת הבטיחות של מודלים, כש- ASL-3 ו- ASL-4 מייצגים רמות סיכון הולכות וגוברות. ככל שהמודלים נהיים חכמים ומסוגלים לבצע מחקרים עצמאיים ופתרון בעיות מורכבות, נדרש פיקוח בטיחותי קפדני על השימוש בהם. באמצעות מערכת של "אם-אז", החברה מצליחה לנטר תרחישים שעלולים להיות מסוכנים ולפעול באופן מדורג ומבוקר.

Claude ככלי לתפעול מרחוק וניהול משימות חכמות

אחד ההיבטים המעניינים ביותר ביכולתו המתפתחת של Claude הוא התפקוד כ״סוכן עצמאי״, עם גישה נרחבת יותר למחשב, המסוגל לבצע ניתוחים ובדיקות בתוך הממשק של Claude.ai, ואף לפעול על גבי מחשב חיצוני באמצעות צילום מסך. היישומים הרבים והאפשרויות ש- Claude מציע מרשימים במיוחד – ניתן להגדיר עבורו משימות, והוא מסוגל לבצע שורה של פעולות, לזהות את המשימה, לבצע אותה, ואף לספק דיווחים מעודכנים על הביצוע.

Claude הותאם ליכולת לקרוא תמונות, כאשר החידוש הפעם הוא בזיהוי וניהול פעולות על מסך מחשב מצולם. במילים אחרות, המודל מונחה להצביע על מיקומים ספציפיים במסך בהם יש ללחוץ, לבצע פעולות על המחשב ואף להקליד, ועם הדרכה מינימלית מסוגל לבצע משימות על מגוון מערכות הפעלה כמו חלונות, לינוקס ו-macOS. כך, Claude יכול למלא טפסים, לפתוח תוכנות ולהשלים משימות מורכבות, תוך הסתמכות על תמונות מסך בלבד – חידוש שמפחית את הצורך בגישה ישירה ל-API ומנגיש את המודל לקהל רחב יותר של משתמשים.

אתגרים בטיחותיים ופתרונות מסגרת לשימוש במחשב

למרות הפוטנציאל המלהיב של יכולת השימוש במחשב, ישנם אתגרים משמעותיים לבטיחות ואמינות המערכת. Claude עדיין נוטה לטעות ולבצע קליקים שגויים, מה שעלול להוות סכנה במקרה של שימוש ממושך ללא השגחה. החברה הקפידה לציין בבלוג שלה אזהרות לשימוש זהיר, כולל המלצות להימנע מהפעלה חופשית ללא הגבלות. המודל הראשון יצא כ-API ולא ככלי לציבור הרחב, בדיוק כדי להתמודד עם מגבלות אלה ולהבטיח שימוש בטוח יותר.

מגבלות אלו אינן מפחיתות מערכו של Claude אלא משמשות כשלב נוסף ללמידה בטוחה, בעוד יכולותיו של המודל משתכללות. כך, לקוחות שונים, כמו Replit, מהראשונים לאמץ את המערכת, החלו להטמיע את הכלי לצרכים שונים ומגוונים, תוך חיבור לתוכנות ולמערכות הפעלה.

אבטחת המערכת והתמודדות עם הונאות

המעבר לתפעול מרחוק מציב סיכונים חדשים, החל מהזרקת קוד זדוני וכלה בהתקפות מהסוג הנפוץ של התחזות וקידום מוצרים (ספאם). מערכות כמו Claude, המקבלות תמונות מסך ובקשות לפעולות, חשופות לתכנים זדוניים שעלולים לשנות את פעולת המודל. אמודאי מדגיש את החשיבות של ביצוע סינון והגנות נוספות, שמונעות פעולות חריגות, לצד הצבת "סנדבוקסים" לאימון והגבלת אינטראקציות עם המודל. Anthropic מפתחת פתרונות אבטחה יצירתיים, המסייעים להימנע מתרחישי שימוש לרעה בעתיד.

סיכום ותחזית לעתיד

הפיתוחים של Anthropic ובפרט של Claude מצביעים על עתיד שבו הבינה המלאכותית תתקרב לרמות ביצוע אנושיות ואף תעלה עליהן בתחומים מסוימים. לצד זאת, השימוש בטכנולוגיה זו דורש פיקוח קפדני וניהול סיכונים מחושב, כדי להבטיח שהיתרונות העצומים של בינה מלאכותית לא יבואו על חשבון הביטחון הציבורי. עם הזמן, יש להניח שנראה מודלים מתוחכמים יותר שמבצעים משימות מורכבות בקנה מידה רחב, ואיתם גם סטנדרטים בטיחותיים מחמירים יותר. העולם עומד בפתח של עידן בו למערכות בינה תהיה השפעה מהותית על חיינו, וכדי לשמור על איזון יש להמשיך לפתח מנגנוני בקרה מתקדמים שיבטיחו שימוש אתי ובטוח.

עברית לא טובה תחליפו כותב